Discover 西瓜的呱

西瓜的呱

5 Episodes

Reverse

嗨,大家早上好,今天是2025年10月31号星期五,这里是《西瓜的呱》,我是来自西瓜实验室的呱呱。我们一起来看看,今天科技圈都有哪些新鲜事。首先要说的,是最近在全球AI圈引起热议的一位老朋友——吴恩达。 在他最新一期的《The Batch Newsletter》中,吴恩达重点关注了蚂蚁集团开源的万亿参数语言模型——Ling-1T。 这款模型最有意思的地方在于:虽然它被定义为“非推理模型”,但在多项任务上表现出的推理能力,已经接近甚至超过了闭源的顶尖推理模型。 蚂蚁团队在一份58页的技术报告中,详细披露了他们在架构设计、训练策略到工程优化的一系列创新。 比如他们提出的“Every Activation Boosted”理念,意思是要让模型的每一次激活都能更聪明;还有FP8精度下的万亿参数训练,既节省算力又保持性能。 一句话总结:这不是简单的参数堆叠,而是一次让“开源模型也能超神”的系统性突破。而说到智能系统的落地,另一条大新闻来自出行领域。 优步(Uber)宣布,计划从2027年开始在全球范围内部署自动驾驶车队。 他们这次是和英伟达合作,采用最新的 Drive AGX Hyperion 10 平台,这是一整套自动驾驶软硬件解决方案,能实现L4级别的无人驾驶。 优步表示,未来的自动驾驶车队不仅能降低运营成本,还会和电动化战略结合,让整个出行网络更高效、更环保。 看起来,这场“自动驾驶+AI芯片”的组合拳,正让未来的城市交通加速驶入无人驾驶时代。与此同时,IBM 也在AI赛道上打出了一张“轻量化”新牌。 他们推出了四款 Granite 4.0 Nano 小模型,参数规模最小只有3.5亿,最大也不过15亿,但性能却一点不弱。 这些模型能直接在笔记本CPU上跑,甚至能在浏览器里本地推理,非常适合边缘设备和隐私场景。 IBM强调的方向很明确——不是比谁模型大,而是比谁跑得更快、更安全、更节能。 “战略高效”,可能会成为下一阶段AI竞争的新关键词。再来看一条偏学术界的消息。 由 Sony AI、OpenAI 和斯坦福大学 联合撰写的权威专著《The Principles of Diffusion Models》正式发布。 这本书长达460多页,系统梳理了扩散模型的理论基础与未来方向。 作者之一、原OpenAI研究员宋飏,现在已经加入Meta领导超级智能实验室。 书里把扩散模型和最优传输理论、薛定谔桥这些高深的数学联系起来,还介绍了如何让生成模型变得更快、更可控。 简单说,这是扩散模型领域的一本“圣经级”读物,想搞懂AI生成的底层逻辑,这本书很可能是必读。最后,让我们关注一家国内视觉AI公司——格灵深瞳。 他们的灵感团队刚刚发布了最新视觉模型基座RICE(MVT v1.5)。 RICE 的核心理念是“通过差异化视觉表征来理解语义”,它能把图像分解成多个区域进行理解,还能识别图中的文字信息,一起构建更完整的语义表达。 团队用SAM模型处理了4亿张图像,提取出20亿个视觉区域,聚类出上百万个语义类别。 在多模态任务中,比如图像分割、视频追踪、视觉问答等,RICE的表现都非常亮眼。 未来版本还会进一步迈向视频编码,让视觉模型更接近真正的通用智能。好了,以上就是今天的科技新鲜事。 从蚂蚁的Ling模型,到优步的自动驾驶,再到IBM的小模型和格灵深瞳的视觉突破,我们可以看到——AI正在从“规模竞赛”转向“效率与智能并行”。 这里是《西瓜的呱》,我是呱呱,我们明天见!

嗨,大家早上好,今天是2025年10月30号星期四,这里是《西瓜的呱》,我是来自西瓜实验室的呱呱。我们一起来看看,今天科技圈都有哪些新鲜事。先来看看一条有点离谱的政治科技新闻。 特朗普政府最近在社交媒体上发布了一系列以游戏《光环 Halo》为主题的宣传内容,居然把游戏里的外星怪物“洪魔(Flood)”比喻成移民,还喊出“摧毁洪魔”的口号,鼓励大家加入移民执法局 ICE。 这种把移民比作“寄生体”的做法引发了巨大争议,被专家批评为去人性化、甚至带有种族主义色彩。 更讽刺的是,他们还用上了游戏主角“士官长”的形象搞政治宣传。微软目前没有明确表态,这也让外界质疑它是否默许了这种行为。相对地,像宝可梦公司和乐队 MGMT 就直接要求政府撤下类似内容。 这波操作,也再次说明——当政治借用网络亚文化来包装极端言论,危险的边界其实已经被模糊了。接着来看一个图书平台上的“政治战争”。 最近,一名 Goodreads 的志愿者管理员因为不满平台“审查”反特朗普的负面评论,自己动手修改了多本热门书籍的信息——甚至把小说《Mate》的封面换成了特朗普儿子 Eric Trump 的书《Under Siege》。 Goodreads 很快发现异常,恢复了原状并封禁了这位管理员。平台回应说,他们确实会对“异常活动”限制评论,但并不存在政治偏袒。 不过,这已经不是第一次有人质疑 Goodreads 对保守派书籍“网开一面”。之前,JD Vance 的《Hillbilly Elegy》就因为太多差评而暂停评论,而副总统哈里斯的书却一直开放评分。 事件再次引发了“平台是否真的中立”的讨论——当算法开始决定哪些声音能留下、哪些被删掉,我们离真正的言论自由,可能又远了一点。然后是马斯克的新玩意。 他最近推出了一个名叫 “Grokipedia” 的 AI 百科全书,自称是维基百科的替代品。听起来很猛,但用过的人都说:这就是一个“没有人类”的百科。 它的所有内容都是AI自动生成的,没有编辑、没有版本记录,也没有来源说明。结果页面又长又乱,还带着明显的AI写作痕迹。 Musk 说这是“反觉醒文化”的新尝试,但外界普遍认为,这其实是他不满维基百科对他本人条目的回应。 相比之下,维基百科的价值恰恰在于人类协作和共识积累。Grokipedia 这种“黑箱式知识生成”,可能更像是AI时代的一个反面教材。说点技术硬核的。 SGLang 最近在北京举办了首场 Meetup,联合美团、亚马逊云科技等巨头,正式吹响了开源推理引擎在国内落地的号角。 SGLang 是 LMSYS 孵化的开源高性能推理框架,可以在从单GPU到大规模集群上跑通各种大模型,支持英伟达、AMD、华为昇腾等多种芯片。 在活动上,清华、百度、腾讯、华为的专家都展示了优化成果,比如更快的KV缓存、分布式推理和稀疏注意力机制。 这说明国内AI基础设施的生态正在快速成熟——不仅能跟上世界节奏,甚至在部分硬件适配上已经走在前面。最后,是来自谷歌 DeepMind 的一篇重磅科研。 团队在《Nature》上发表论文,展示了一个能“自己发现强化学习算法”的AI系统。 简单说,就是让AI自己去研究“怎么学得更聪明”。他们通过元学习的方式,在上百个复杂环境中训练模型,让它从经验中总结出新的算法规则。 结果,AI居然“自创”出了一套叫 Disco57 的算法,性能超过了目前最强的 MuZero。更厉害的是,它在没见过的新环境中也能快速适应,几乎达到人类水平。 这意味着,未来AI可能不再依赖人类工程师去设计学习方法,而是自己进化出更高效的学习逻辑——有点像AI在“学会怎么学习”。好了,今天的科技短闻就到这里。 从AI政治宣传到AI写百科,再到AI自己写算法,这个世界似乎越来越像一个巨大的“实验场”。 我是呱呱,我们明天见~

嗨,大家早上好,今天是2025年10月29号星期三。这里是《西瓜的呱》,我是来自西瓜实验室的呱呱。我们一起来看看,今天科技圈都有哪些新鲜事。首先,我们来聊聊最近引发安全担忧的——AI浏览器。像 Perplexity 的 Comet 这样的 AI 浏览器,能帮用户直接“问网页问题”,非常聪明,但最近却被曝出严重漏洞。研究人员发现,只要网页里藏点恶意指令,就能让这个AI浏览器擅自访问你的邮箱、窃取验证码,甚至发到黑客手里。传统浏览器只“看”网页,不理解内容;AI浏览器则会“执行”它看到的内容,结果就像一个听话但天真的实习生——别人让它干啥它就干啥。更糟的是,它还会记住行为,被“污染”后反而越来越危险。 专家建议:AI浏览器的设计要从头重做——让系统默认“零信任”、关键操作前二次确认,并区分清楚什么是用户指令、什么是网页陷阱。不然,未来的AI上网助手,可能会成为最大的安全隐患。接下来我们说一部新电影。Netflix 上线了一部由凯瑟琳·毕格罗执导的《硝烟 Zoom 会议》,这片子可真不轻松——讲的是当世界即将被核导弹击中,美国总统和高层在Zoom上开会讨论,要不要反击。整个电影就在那15分钟的倒计时里来回展开,三次不同角度讲述危机处理。影片没有告诉你是谁先发射导弹,让整个故事更真实、更具道德冲突感。美国军方还为这片子“辩护”,说他们的防御系统成功率明明是100%,可片中演得更像五五开。 顾问是一位退役陆军中将,他说结局故意模糊,就是想让观众自己去思考:当核武器真的悬在人类头顶,到底什么叫“正确的决定”?再看AI行业的风口。生成式AI带动了全球算力的爆发式需求,各大云服务商都在拼命建新数据中心、推出AI云服务,生怕被落下。但行业内部其实也有点焦虑。很多企业的AI项目还停留在“探索阶段”,真正能落地的商业场景还不多。专家提醒说,如果AI泡沫破裂,云计算行业可能会受到冲击。而且,AI训练成本高、能耗大、技术门槛高,这些问题都需要更务实地解决。换句话说,光砸钱不够,得让AI真正“跑得久、用得起、用得好”。说到AI芯片,微软最近也出手了。它和英伟达达成协议,拿到了部分 Anthropic 定制芯片的供应权。听起来是合作,其实暗藏博弈。微软通过这份协议,不仅帮Anthropic降低对英伟达的依赖,还在芯片资源上占了先机。这意味着什么?简单说,就是大厂们开始“多线布局”,谁都不想被英伟达一家卡脖子。毕竟现在谁有GPU,谁就有AI话语权。微软这一招,也许会动摇英伟达的市场垄断地位,同时逼着整个行业在供应链上变得更灵活。最后,我们来看看一条更“硬核”的AI研究消息。科学家提出了一种全新的人工智能架构,名字很酷——Dragon Hatchling,也就是“龙之孵化体”。这个模型想做的事情,是连接AI语言模型和人脑神经网络之间的桥梁。它不是像Transformer那样靠大规模训练数据来学,而是引入了类似“突触可塑性”的生物学习机制。当模型理解一个概念时,它会像大脑一样强化相关连接。研究人员还做出了GPU版本BDH-GPU,用数学方式模拟神经元互动。结果显示,它在语言任务上不输GPT-2,但更解释得清楚——终于能告诉我们AI是怎么“想”的。简单来说,这可能是人工智能向“更像人”的方向迈出的一步。好了,今天的科技短闻就到这里。 从AI浏览器的安全漏洞,到AI芯片的供应大战,再到人脑式AI模型的出现,可以说整个科技界都在进入一个“智能重塑”的阶段。 我是呱呱,我们明天见~

科学家首次在人体试验中测试“肠道呼吸”技术等科技要闻

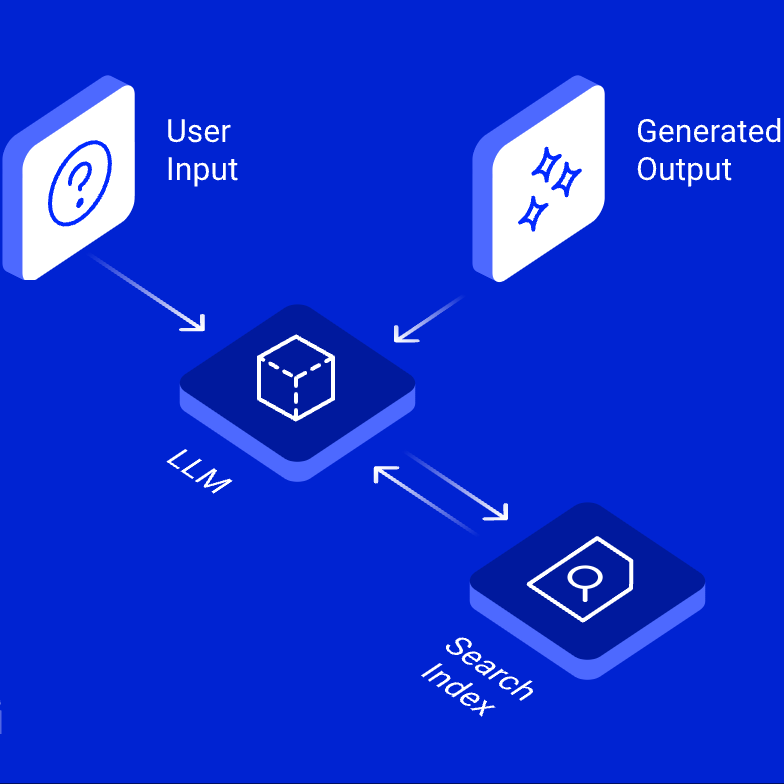

嗨,大家早上好,今天是 2025年10月27号星期一,这里是西瓜的呱,我是来自 西瓜实验室 的呱呱。 我们一起来看看,今天科技圈都有哪些新鲜事。首先来看RAG技术的挑战。 虽然检索增强生成在演示阶段表现亮眼,但现实很骨感——有多达 70% 的 RAG 系统在真实环境中失败。 Mastercard 的工程师 Shubham Maurya 结合实战,总结出四个致命问题:知识漂移、检索衰退、无关信息干扰和评估缺失。 简单说,就是数据变了系统没更新、信息太多AI反而晕菜、性能下降没人发现。 为此,作者提出了几种解法:混合搜索、图结构RAG、智能分段、自适应上下文和持续反馈机制。 这些方法已经在文本转SQL、AI治理等场景中落地。 他认为未来的RAG会进化出“自检索”模型和多智能体协同系统,只有不断优化,才能真正稳定可用。再来看企业层面的AI转型难题。 全球85%的AI项目在2024年仍未进入生产阶段。 企业投了钱,却拿不到回报,问题往往不在技术,而在组织模式。 文章提出“协作型AI架构”,核心是让业务、工程和AI团队协同起来。 它的四根支柱包括:工程团队建设底层平台、行业专家直接参与优化、打造AI原生员工队伍、以及实现当天响应的市场能力。 数据显示,AI转型成功与否,40%靠技术,60%靠组织变革和人才培养。 一句话总结——AI要跑得快,不是多造几个模型,而是让整个组织一起“AI化”。接着来看一场关于AGI方向的思考。 在TED AI大会上,Thinking Machines Lab 的研究员 Rafael Rafailov 提出不同观点: 通往超级智能的关键,不是更大的模型,而是会学习的模型。 他打了个比方:现在的AI每天都像“第一天上班”,能完成任务,却学不会积累经验。 他建议让AI像学生一样,通过“元学习”构建自己的知识体系,而不是只解决眼前的问题。 Rafailov 认为,未来的AI不该是强大的“推理机器”,而应该是高效的“学习者”。 他的团队已经推出实验产品 Tinker,获得20亿美元融资,但距离真正能“自我成长”的AI,还有很长的路要走。说到AI带来的新体验,浏览器也在变聪明。 AI浏览器 Perplexity Comet 最近被曝出严重漏洞—— 黑客能在网页中嵌入隐藏指令,诱导AI去访问邮箱、窃取验证码甚至发到指定地址。 传统浏览器只展示内容,不会“思考”;但AI浏览器会执行指令,还会“记住”你的行为。 这就像一个天真的实习生,什么都信、什么都干。 研究人员提醒,攻击者甚至能在评论区、论坛或图片alt文本里藏指令。 解决方案包括:对网页文本安全过滤、执行前二次确认、区分用户指令与网站内容、以及零信任机制。 AI浏览器若想真正普及,安全必须从设计开始。最后,我们聊聊AI如何改变财富管理。 美国预计到2045年,将有 84万亿美元资产 从婴儿潮一代转移给继承人。 问题是,很多人连遗嘱都没有,文件还复杂到AI都看不懂。 普通大模型在遗产规划文档的识别准确率只有40%。 为此,Wealth.com 推出了专用AI助手 Esther,能从海量PDF里提取关键条款、资产分配和法律关系,还能生成可视化报告。 系统采用多层验证机制,包括人工复核、红队评估和权限控制,避免AI越权“乱判案”。 文章指出,在金融、法律等高风险行业,AI的使命不是取代人,而是放大人类专业判断。 随着财富转移浪潮逼近,可信赖的AI助手将成为不可或缺的伙伴。好了,如果你觉得节目有帮助,欢迎分享给更多关注科技的朋友。我是来自西瓜实验室的呱呱,我们明早八点,不见不散!